Meta Dévoile Llama 4 : Modèles d'IA Open Source de Nouvelle Génération

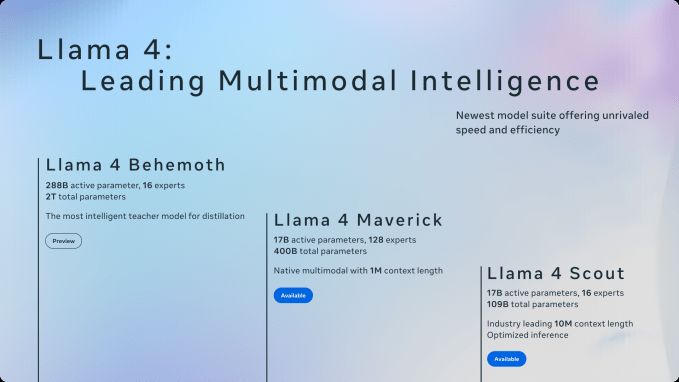

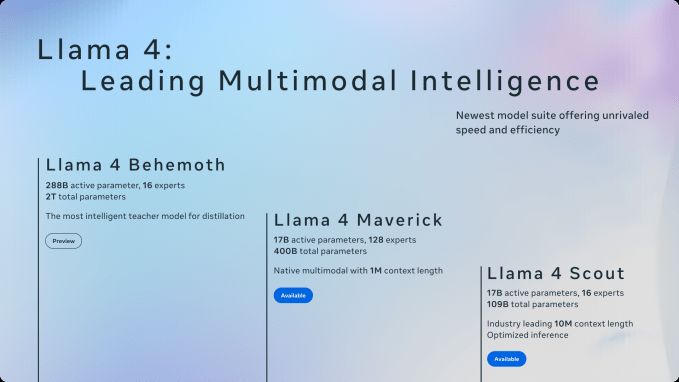

Meta vient de lancer ses derniers modèles d'IA, la famille Llama 4, marquant une étape importante dans le paysage de l'IA open source. Cette nouvelle collection comprend Llama 4 Scout, Llama 4 Maverick et Llama 4 Behemoth. Ces modèles ont été entraînés sur un ensemble de données massif de texte, d'image et de vidéo non étiquetés afin d'obtenir une **large compréhension visuelle**.

Le développement de Llama 4 aurait été accéléré en raison du succès des modèles ouverts du laboratoire chinois d'IA DeepSeek, qui ont surpassé les modèles Llama précédents de Meta. Meta a répondu en intensifiant ses efforts pour comprendre comment DeepSeek a réussi à réduire les coûts associés à l'exécution et au déploiement de modèles tels que R1 et V3.

Llama 4 Scout et Maverick sont facilement disponibles sur Llama.com et par l'intermédiaire de partenaires de Meta tels que Hugging Face. Cependant, Behemoth est toujours en cours de formation. Meta AI, l'assistant alimenté par l'IA intégré aux applications telles que WhatsApp, Messenger et Instagram, a déjà été mis à jour avec Llama 4 dans 40 pays, bien que les fonctionnalités multimodales soient actuellement limitées aux États-Unis en anglais.

Restrictions de Licence

Certains développeurs pourraient trouver la licence Llama 4 restrictive. Les entités domiciliées dans l'UE sont interdites d'utiliser ou de distribuer les modèles, probablement en raison des lois strictes de la région en matière de confidentialité des données et d'IA. De plus, comme pour les versions précédentes de Llama, les entreprises comptant plus de 700 millions d'utilisateurs actifs mensuels doivent demander une licence spéciale à Meta, que Meta peut approuver ou refuser à sa discrétion.

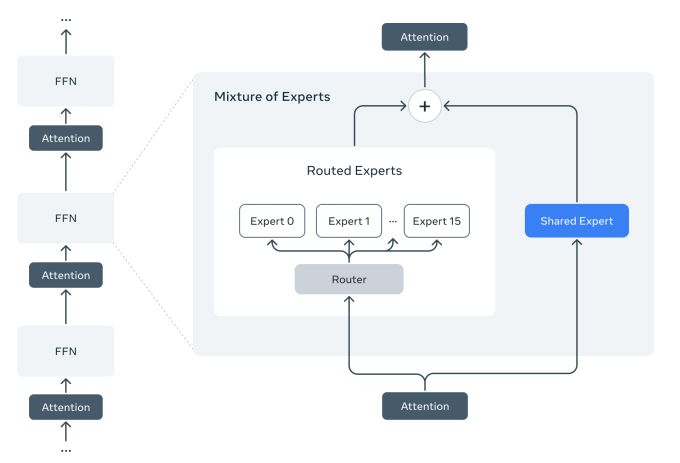

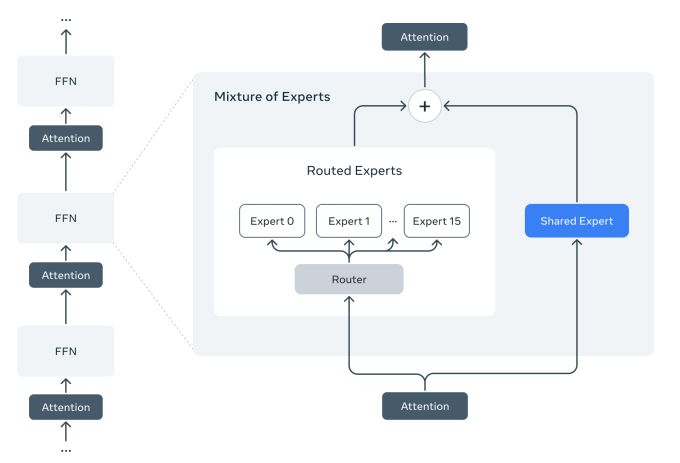

Meta souligne que les modèles Llama 4 représentent le début d'une nouvelle ère pour l'écosystème Llama. Ces modèles sont les premiers à utiliser une architecture de mélange d'experts (MoE), ce qui améliore l'efficacité informatique pour l'entraînement et les réponses aux requêtes. L'architecture MoE divise le traitement des données en sous-tâches, en les affectant à des modèles « experts » plus petits et spécialisés.

Par exemple, Maverick compte 400 milliards de paramètres au total, mais seulement 17 milliards de paramètres actifs répartis entre 128 experts. Scout possède 17 milliards de paramètres actifs, 16 experts et 109 milliards de paramètres au total.

Performances et Capacités

Les tests internes de Meta suggèrent que Maverick, conçu pour les cas d'utilisation généraux d'assistant et de chat, surpasse des modèles tels que GPT-4o d'OpenAI et Gemini 2.0 de Google dans le codage, le raisonnement, les tâches multilingues, la compréhension du contexte long et les benchmarks d'image. Cependant, il n'atteint pas des modèles tels que Gemini 2.5 Pro de Google, Claude 3.7 Sonnet d'Anthropic et GPT-4.5 d'OpenAI.

Scout excelle dans le résumé de documents et le raisonnement sur de vastes bases de code. Sa caractéristique distinctive est son énorme fenêtre de contexte de 10 millions de jetons, ce qui lui permet de traiter et de travailler avec des documents extrêmement longs. Scout peut fonctionner sur un seul GPU Nvidia H100, tandis que Maverick nécessite un système Nvidia H100 DGX ou équivalent.

Behemoth, le modèle non publié de Meta, exige un matériel encore plus puissant, avec 288 milliards de paramètres actifs, 16 experts et près de deux billions de paramètres au total. Les benchmarks de Meta montrent que Behemoth surpasse GPT-4.5, Claude 3.7 Sonnet et Gemini 2.0 Pro dans les évaluations des compétences STEM, telles que la résolution de problèmes mathématiques.

Il convient de noter qu'aucun des modèles Llama 4 n'est un véritable modèle de « raisonnement » comme o1 et o3-mini d'OpenAI. Les modèles de raisonnement privilégient la vérification des faits, ce qui conduit à des réponses plus fiables, mais à des temps de traitement plus longs.

Lutter Contre les Préjugés et les Questions Contentieuses

Meta a également ajusté Llama 4 pour qu'il soit plus disposé à répondre aux questions « contentieuses ». Les modèles répondent désormais à des sujets politiques et sociaux débattus que les modèles Llama précédents évitaient. Meta affirme que Llama 4 est plus équilibré dans le traitement des invites qu'il n'aurait pas prises en compte auparavant.

Selon un porte-parole de Meta, Llama 4 fournit des réponses utiles et factuelles sans porter de jugement et est plus réceptif à divers points de vue. Ces ajustements interviennent dans un contexte d'accusations d'alliés de la Maison Blanche selon lesquelles les chatbots d'IA sont politiquement biaisés.

Les préjugés dans l'IA restent un défi technique complexe, et des entreprises comme OpenAI et xAI travaillent constamment à créer des modèles qui ne favorisent pas de manière disproportionnée certains points de vue politiques.

2 Images de Llama 4:

Source: TechCrunch